Embending是什么

降维

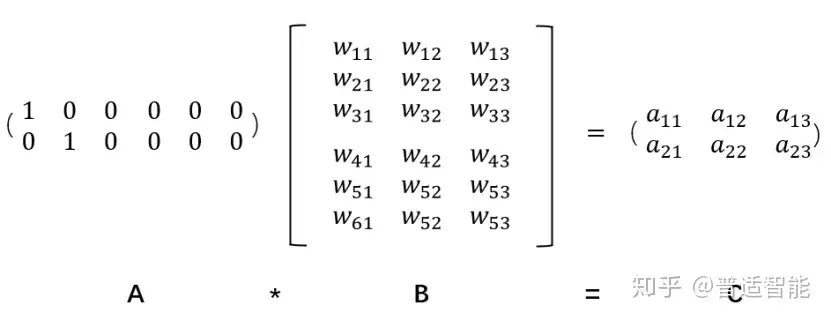

假设:我们有一个2 x 6的矩阵,然后乘上一个6 x 3的矩阵后,变成了一个2 x 3的矩阵。

Embedding层,在某种程度上,就是用来降维的,降维的原理就是矩阵乘法。

假如我们有一个100W X10W的矩阵,用它乘上一个10W X 20的矩阵,我们可以把它降到100W X 20,瞬间量级降了10W/20=5000倍!!!

这就是嵌入层的一个作用——降维。

升维

接着,既然可以降维,当然也可以升维。

对低维的数据进行升维时,可能把一些其他特征给放大了,或者把笼统的特征给分开了。

语义理解中Embedding意义

理解了它是沟通两个世界的桥梁后,我们再看个例子,它是如何运用在文本数据中的?

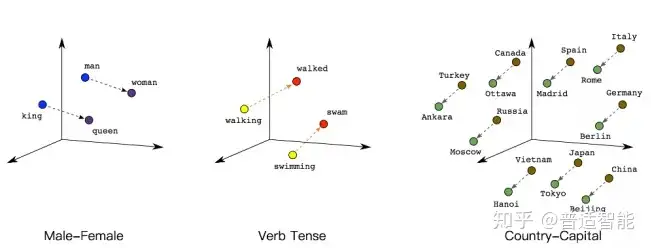

如下图所示,我们可以通过将两个无法比较的文字映射成向量,接下来就能实现对他们的计算。

例如:

queen(皇后)= king(国王)- man(男人)+ woman(女人)

这样计算机能明白,“皇后啊,就是女性的国王呗!”

walked(过去式)= walking(进行时)- swimming(进行时)+ swam(过去式)

| 同理计算机也能明白,“walked,就是walking的过去式啦!”另外,向量间的距离也可能会建立联系,比方说“北京”是“中国”的首都,“巴黎”是“法国”的首都,那么向量: | 中国 | - | 北京 | = | 法国 | - | 巴黎 |

This post is licensed under CC BY 4.0 by the author.